양자역학 기초: 큐비트 이해하기

소개

양자역학은 떠오르는 분야인 양자 컴퓨팅의 기반이 되며, 특정 작업에서 기존 컴퓨팅 시스템을 능가할 수 있는 계산 방식을 제시합니다. 양자 컴퓨팅의 핵심에는 큐비트(qubit)가 있습니다. 큐비트는 고전적 비트의 양자적 대응물로, 중첩(superposition)과 얽힘(entanglement) 같은 양자역학적 현상을 활용할 수 있다는 점에서 차별화됩니다.

이 글은 양자역학 시리즈의 첫 번째 글로, 큐비트의 이론적 기초, 주요 특성, 그리고 물리적 구현 방법을 자세히 살펴봅니다. 수학적, 물리적 기반을 심층적으로 다루어 독자들이 이 양자 정보의 기본 단위를 탄탄하게 이해할 수 있도록 하는 것이 목표입니다.

1. 큐비트: 고전적 비트의 양자적 확장

1.1 고전적 비트

고전 컴퓨팅에서는 정보가 비트에 저장되며, 각 비트는 서로 배타적인 두 상태(0 또는 1) 중 하나를 가집니다. 예를 들어, \(1010\) 같은 비트열은 데이터를 나타내거나 결정론적 논리 게이트를 통해 처리됩니다. 이 단순한 이진 시스템은 기본 산술 연산부터 복잡한 머신러닝 알고리즘에 이르기까지 모든 고전적 계산의 토대가 됩니다.

1.2 큐비트: 정의와 수학적 표현

큐비트(qubit, quantum bit)는 양자역학을 이용해 고전적 비트를 확장한 것입니다. 고전적 비트와 달리, 큐비트는 중첩 상태로 존재할 수 있으며, 이는 다음과 같은 기저 상태들의 선형 결합으로 표현됩니다:

\[ |\psi\rangle = \alpha |0\rangle + \beta |1\rangle \]

여기서 \(\alpha\)와 \(\beta\)는 복소수(진폭)이며, 정규화 조건을 만족합니다:

\[ |\alpha|^2 + |\beta|^2 = 1 \]

여기서 \(|\alpha|^2\)와 \(|\beta|^2\)는 각각 큐비트를 \(|0\rangle\) 또는 \(|1\rangle\) 상태로 측정할 확률을 의미합니다. 예를 들어, 큐비트가 다음 상태에 있을 경우:

\[ |\psi\rangle = \frac{1}{\sqrt{2}} |0\rangle + \frac{1}{\sqrt{2}} |1\rangle \]

0으로 측정될 확률과 1로 측정될 확률이 각각 50%가 됩니다.

1.3 중첩: 다중 상태의 힘

중첩(superposition)은 큐비트가 0과 1을 동시에 표현할 수 있게 해주며, 여러 큐비트가 있을 때 이 능력은 지수적으로 확장됩니다. \(n\)개의 큐비트가 있을 때 전체 상태는 \(2^n\)개의 기저 상태들의 중첩으로 표현됩니다:

\[ |\psi\rangle = \sum_{x=0}^{2^n-1} c_x |x\rangle, \quad \sum |c_x|^2 = 1 \]

예를 들어, 두 큐비트는 다음과 같은 상태에 있을 수 있습니다:

\[ |\psi\rangle = \frac{1}{2} |00\rangle + \frac{1}{2} |01\rangle + \frac{1}{2} |10\rangle + \frac{1}{2} |11\rangle \]

이로 인해 양자 컴퓨터는 여러 입력값을 동시에 처리할 수 있으며, 이는 양자 컴퓨터의 계산적 잠재력의 핵심 요소입니다.

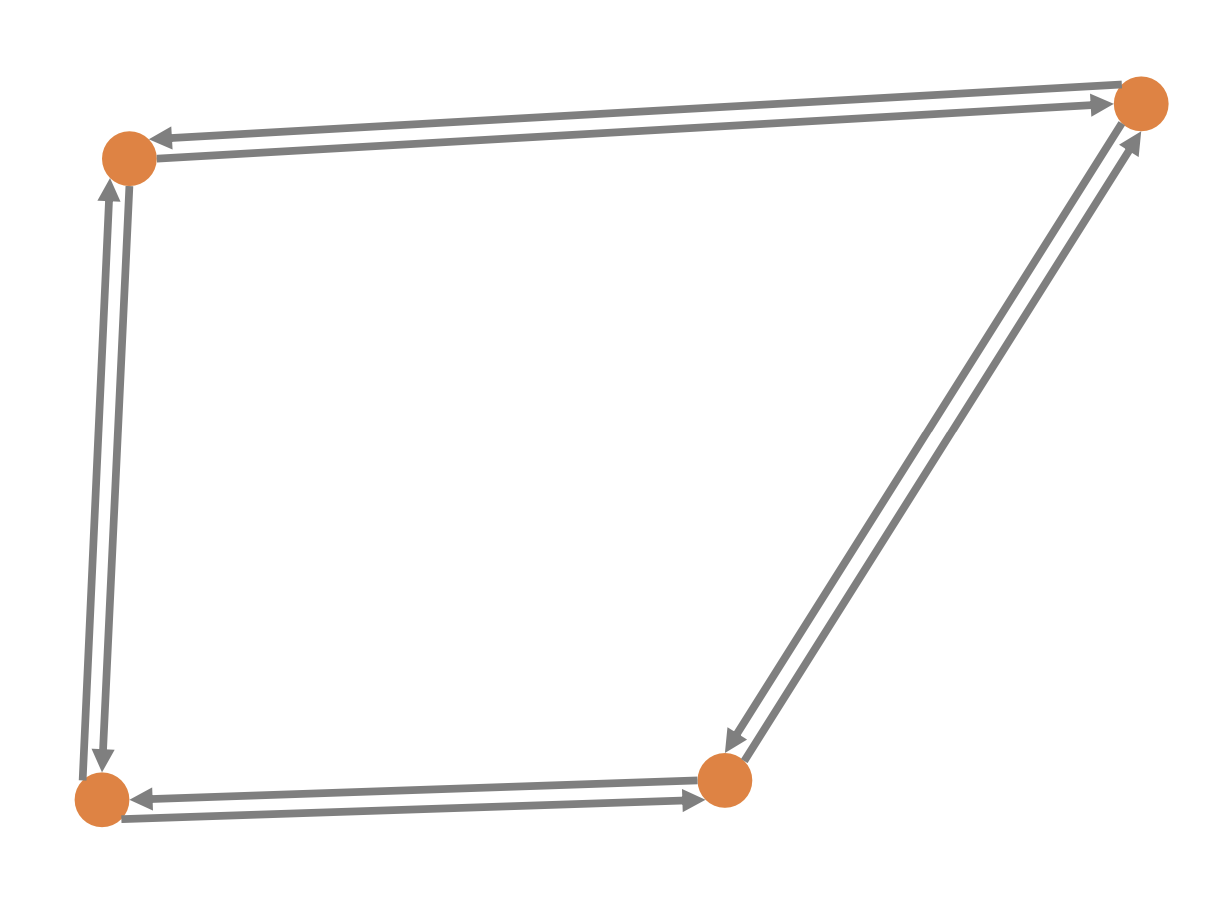

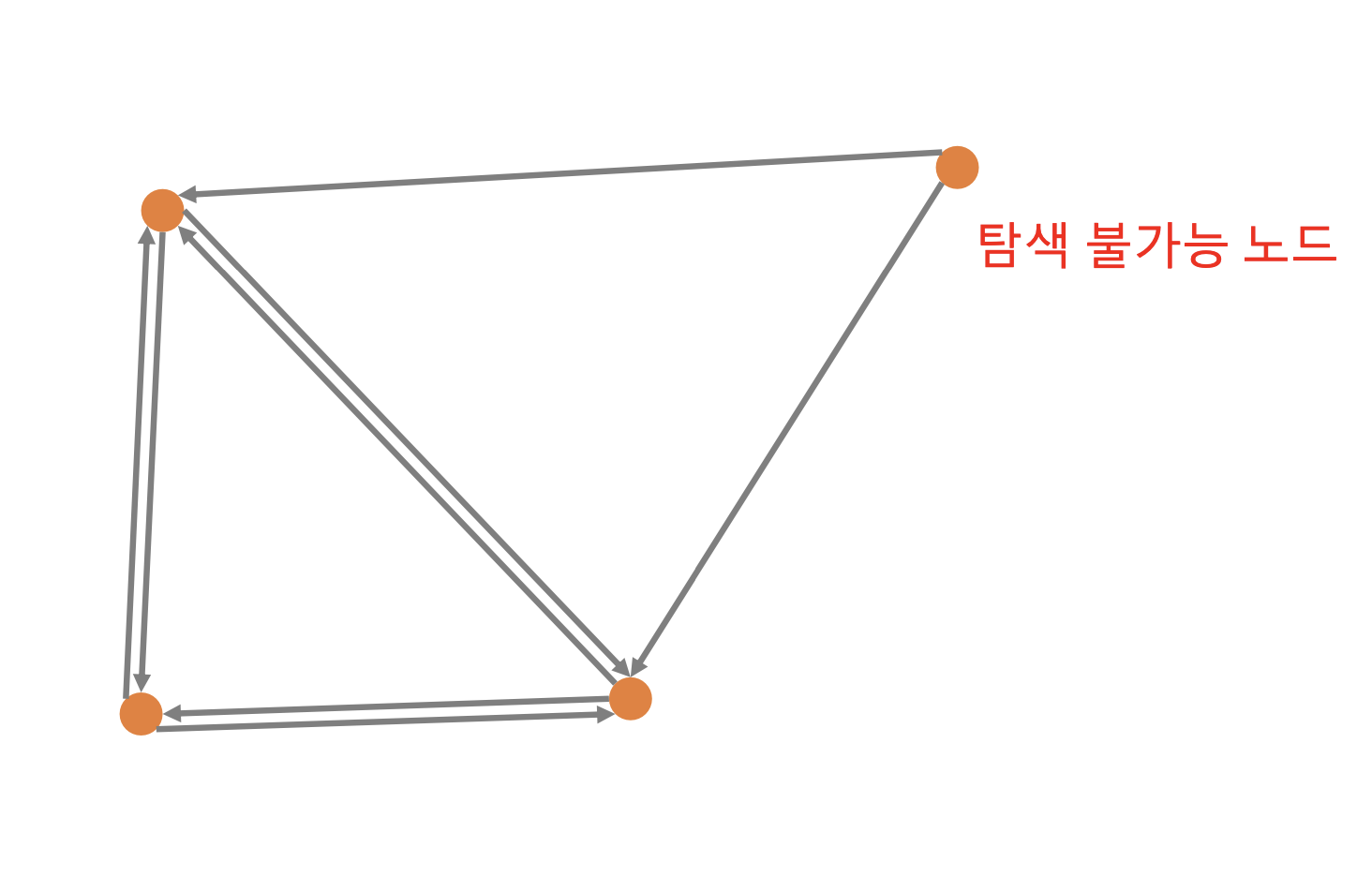

2. 얽힘: 고유한 양자 현상

얽힘(entanglement)은 두 개 이상의 큐비트 상태가 서로 강하게 연결되어, 한 큐비트의 상태를 단독으로 설명할 수 없는 양자역학적 현상입니다. 대표적인 두 큐비트 얽힘 상태(벨 상태)는 다음과 같습니다:

\[ |\Phi^+\rangle = \frac{1}{\sqrt{2}} (|00\rangle + |11\rangle) \]

만약 첫 번째 큐비트를 \(|0\rangle\)로 측정하면, 두 번째 큐비트도 반드시 \(|0\rangle\)로 측정됩니다. 이 현상은 두 큐비트가 공간적으로 멀리 떨어져 있어도 마찬가지로 적용되며, 아인슈타인이 "거리 너머의 유령 같은 작용"이라고 묘사했던 것입니다.

얽힘은 고전적 시스템으로는 구현할 수 없는 의존성을 만들어내어 계산 효율성을 향상시킵니다. 예를 들어, 쇼어(Shor)의 알고리즘에서는 입력과 출력 큐비트 간의 얽힘을 통해 대수적 패턴을 인코딩하여 큰 수를 빠르게 인수분해합니다.

3. 큐비트의 물리적 구현

중첩과 얽힘을 활용하기 위해서는 양자적 특성을 지닌 물리적 시스템 안에서 큐비트를 구현해야 합니다. 대표적인 세 가지 구현 방식을 소개합니다.

3.1 초전도 큐비트

초전도 큐비트는 IBM, Google 같은 기업에서 가장 많이 사용하는 플랫폼 중 하나입니다.

원리

초전도 큐비트는 조셉슨 접합(Josephson junction)을 이용해 제작된 초전도 회로를 사용하며, 전기 저항을 제거하기 위해 극저온(10–20 mK)에서 동작합니다. 큐비트는 회로의 양자화된 에너지 준위로 인코딩되며, 이는 종종 초전류 방향(시계 방향, 반시계 방향) 또는 전하 상태로 나타납니다.

작동 방식

- 상태 조작: 마이크로파 펄스를 이용해 \(|0\rangle\)과 \(|1\rangle\) 상태 간 전이를 유도하거나 중첩을 만듭니다.

- 판독: 큐비트는 공진자에 결합되어 있으며, 공진 주파수의 변화를 측정하여 상태를 판별합니다.

예시

IBM의 127큐비트 "Eagle" 프로세서는 트랜스몬 큐비트(transmon qubit)를 사용합니다. 이는 개선된 코히런스 시간을 특징으로 합니다.

도전 과제

- 디코히런스: 환경과 상호작용하여 중첩과 얽힘이 사라질 수 있어, 극저온 및 차폐 기술이 필요합니다.

- 확장성: 오류율을 낮춘 채 큐비트 수를 늘리려면 고급 오류 수정 기술이 필수입니다.

수학적 설명

트랜스몬 큐비트의 해밀토니안은 다음과 같이 근사할 수 있습니다:

\[ H = 4E_C (n - n_g)^2 + \frac{E_J}{2} (1 - \cos\phi) \]

여기서 \(E_C\)는 충전 에너지, \(E_J\)는 조셉슨 에너지, \(n\)은 전하 수 연산자, \(\phi\)는 위상 차이를 나타냅니다. 이 모델은 \(|0\rangle\)과 \(|1\rangle\) 상태를 정의하는 에너지 준위를 설명합니다.

3.2 트랩된 이온 큐비트

트랩된 이온 큐비트는 개별 이온을 전자기장으로 가두어 양자 상태를 조작합니다. IonQ와 Quantinuum 같은 기업이 이 방식을 채택하고 있습니다.

원리

전하를 띤 원자(이온)를 전자기장에 가두고, 레이저 펄스를 이용해 이온의 전자 준위를 조작하여 큐비트로 사용합니다.

작동 방식

- 상태 조작: 특정 파장의 레이저를 사용해 \(|0\rangle\)과 \(|1\rangle\) 상태 사이를 전환하거나 중첩 상태를 만듭니다.

- 얽힘: 공진된 모드(집단 진동 모드)를 통해 다수의 이온 간 얽힘을 생성합니다.

예시

IonQ는 고유한 이온 트랩 기술을 활용하여 20큐비트 이상의 고품질 얽힘을 구현했습니다.

도전 과제

- 스케일링: 많은 이온을 개별적으로 제어하고 판독하는 것은 기술적으로 매우 어렵습니다.

- 속도: 큐비트 게이트 속도가 초전도 큐비트에 비해 느린 편입니다.

수학적 설명

트랩된 이온 시스템에서 이온 간 상호작용은 다음과 같은 형태로 모델링할 수 있습니다:

\[ H = \sum_i \frac{\omega_0}{2} \sigma_z^{(i)} + \sum_{i<j} J_{ij} \sigma_x^{(i)} \sigma_x^{(j)} \]

여기서 \(\omega_0\)는 큐비트 간격, \(J_{ij}\)는 이온 간 상호작용 세기, \(\sigma\)는 파울리 행렬을 나타냅니다.

3.3 광자 큐비트

광자 큐비트는 빛의 입자인 광자를 기반으로 양자 정보를 인코딩합니다. Xanadu, PsiQuantum 같은 기업이 주도적으로 연구 중입니다.

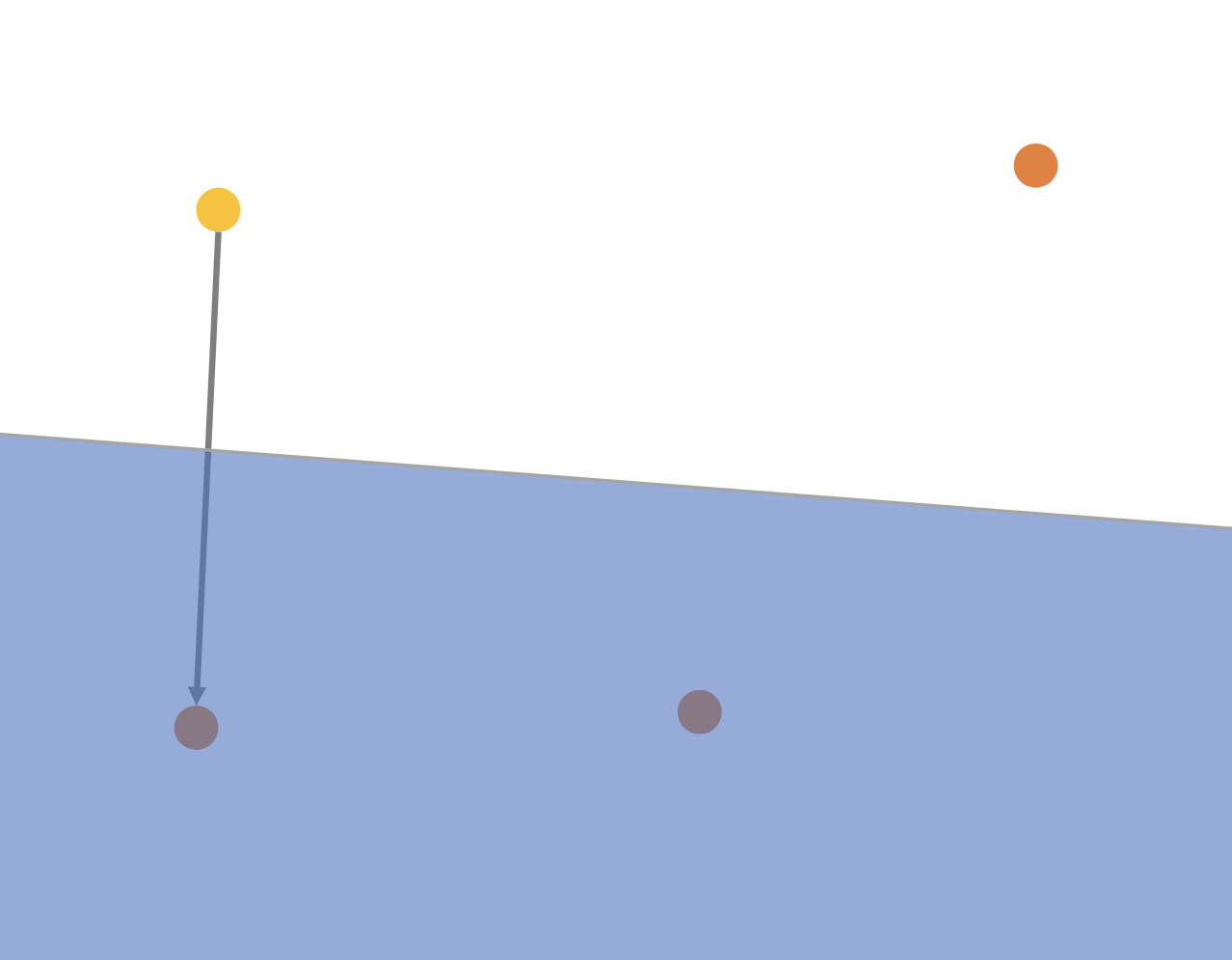

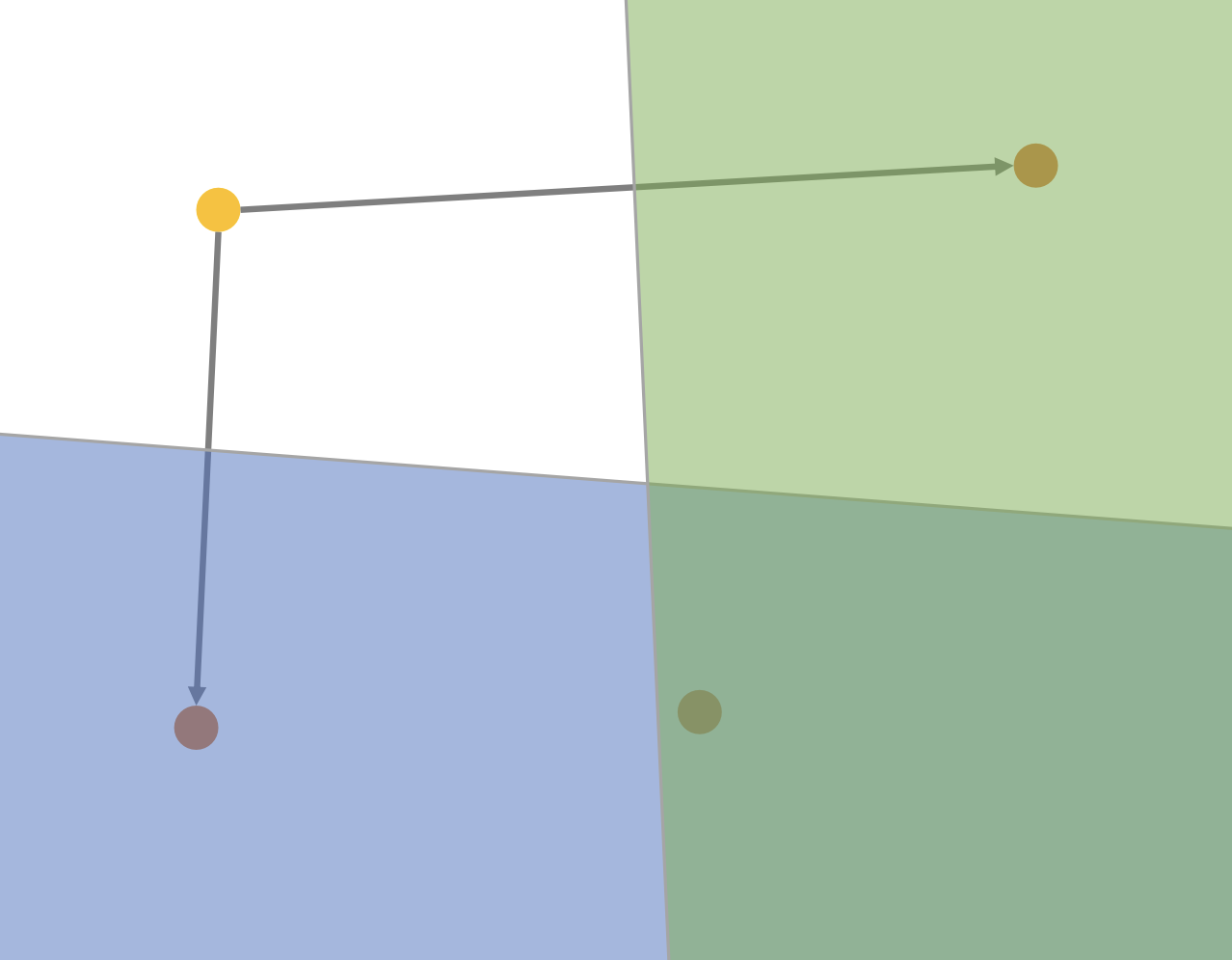

원리

광자의 편광(polarization) 상태, 위상(phase), 경로(path) 등을 사용하여 \(|0\rangle\)과 \(|1\rangle\)을 인코딩합니다.

작동 방식

- 상태 조작: 빔 스플리터(beam splitter), 위상 시프터(phase shifter) 같은 광학 소자를 이용해 광자 상태를 조작합니다.

- 얽힘: SPDC(Spontaneous Parametric Down-Conversion) 같은 과정을 통해 얽힌 광자 쌍을 생성합니다.

예시

Xanadu는 광자 기반의 양자 컴퓨터를 개발하여 "Gaussian boson sampling" 작업에서 고전적 컴퓨터를 능가하는 결과를 발표했습니다.

도전 과제

- 광자 손실: 장거리 전송 중 광자가 소멸할 수 있어 오류 수정이 까다롭습니다.

- 얽힘 생성률: 고품질 얽힌 광자쌍을 대규모로 생성하는 데 기술적 도전이 있습니다.

수학적 설명

광자 상태는 포크 상태(Fock state)로 기술할 수 있으며, 하나의 광자 상태는 다음과 같이 표현됩니다:

\[ |1\rangle = \hat{a}^\dagger |0\rangle \]

여기서 \(\hat{a}^\dagger\)는 생성 연산자(creation operator)입니다.

4. 결론

큐비트는 고전적 비트와 달리 양자 중첩과 얽힘이라는 독특한 특성을 지니며, 이는 양자 컴퓨터가 특정 문제를 고전적 컴퓨터보다 훨씬 빠르게 해결할 수 있게 합니다. 다양한 물리적 플랫폼—초전도 큐비트, 트랩된 이온 큐비트, 광자 큐비트—는 각각 장단점을 지니고 있으며, 기술적 진보에 따라 향후 표준 플랫폼이 결정될 것입니다.

양자 컴퓨팅의 궁극적인 성공 여부는 코히런스 시간, 오류율, 확장성, 제어의 정밀도 같은 요소들에 달려 있습니다. 미래의 양자 기술을 깊이 이해하고 기여하기 위해서는 큐비트의 물리적 구현과 이론적 토대를 모두 탄탄히 이해하는 것이 필수적입니다.

참고문헌

- M. A. Nielsen, I. L. Chuang, Quantum Computation and Quantum Information, Cambridge University Press (2000).

- J. Preskill, "Quantum Computing in the NISQ era and beyond," Quantum 2, 79 (2018).

- IBM Quantum, "What is a qubit?" quantum-computing.ibm.com

- IonQ, "How trapped ions work," ionq.com

- Xanadu Quantum Technologies, "Photonic quantum computing," xanadu.ai